- 74 高校采购信息

- 3398 科技成果项目

- 0 创新创业项目

- 0 高校项目需求

3D闪存存储器件可靠性模型与纠错码技术

1. 建立通用的高精度3D闪存器件可靠性模型

基于多种3D闪存芯片的测试数据集,采用机器学习方法,将3D闪存器件中存在的多维噪音干扰和多层结构差异因素作为输入,建立通用的高精度3D闪存器件可靠性模型。首先,采取适用于拟合光滑曲线的浅层神经网络,建立闪存单元阈值电压分布模型。该模型能够提供更精准的纠错码译码信息和读参考电压,从而提高数据读取速度和降低比特错误率。然后,考虑到3D闪存堆叠层次间原始误码率分布呈现非平滑的锯齿状分布,采用基于梯度提升决策树的集成学习方法建立闪存单元原始比特错误率分布模型。该模型有助于发掘和预测闪存单元原始比特错误率变化趋势和分布特征,从而为设计可靠性优化技术提供依据。

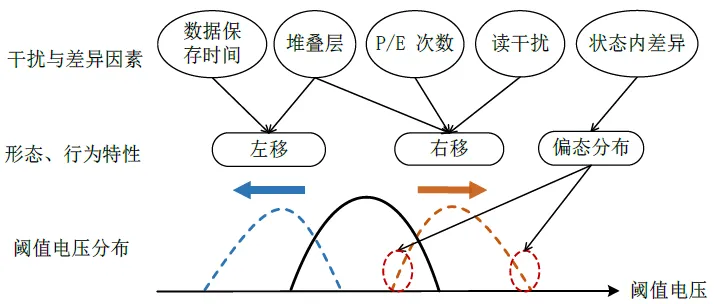

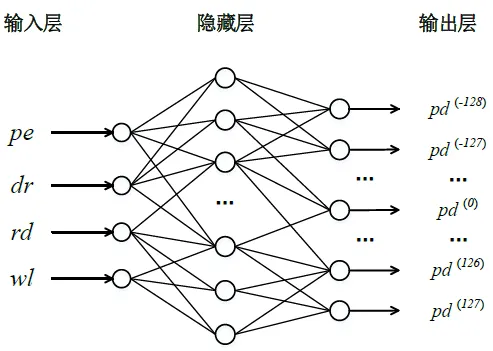

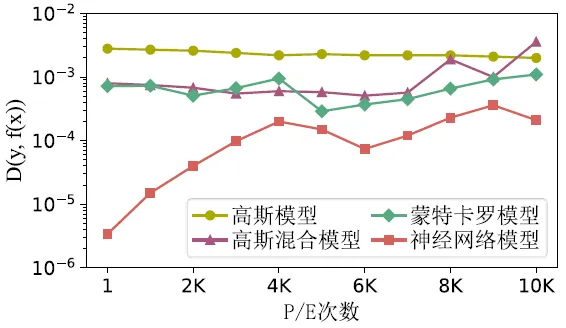

通过分析影响3D闪存阈值电压分布的相关因素,包括数据保存时间、堆叠层、可编程擦写次数(Program/Erase, P/E)、读干扰和状态内差异,如图1所示。利用神经网络模型对3D闪存阈值电压分布模型进行预测,将P/E次数记为pe、数据保存时间记为dr,读次数记为rd和字线记为wl作为神经网络的输入,阈值电压分布的离散点作为输出,如图2所示。提出的建模方法相比传统的建模方法能够提升预测精度,如图3和图4所示。

图1 3D NAND闪存阈值电压分布的干扰与差异因素

图2 3D NAND闪存阈值电压分布神经网络模型

图3 预测值和实际值对比

图4 提出的方案和传统方案的精度对比

2. 高性能LDPC纠错码

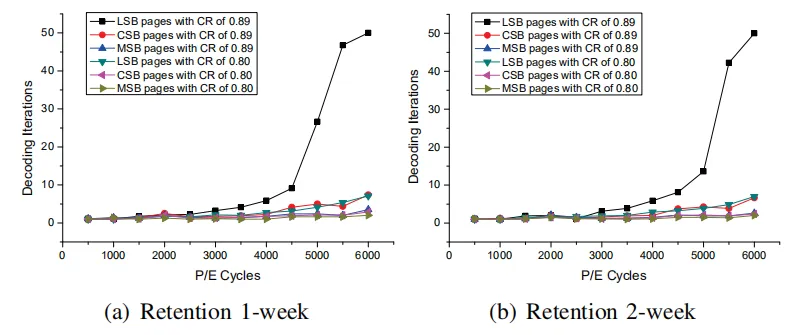

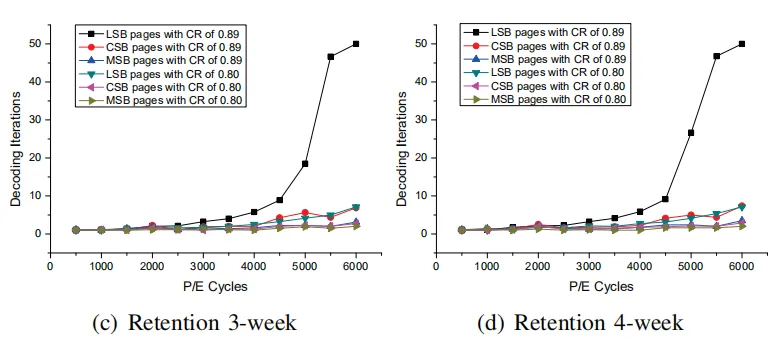

对于3D闪存而言,随着数据保存时间和可编程擦写周期的增加,原始误码率较高,引起较多的译码迭代次数,引起高的译码延迟问题。为了降低译码迭代次数和译码延迟,提出比特错误感知的自适应码率的LDPC方案。首先基于FPGA硬件测试平台,研究三维电荷俘获型TLC闪存比特错误特征。然后利用这些特征研究强纠错能力的LDPC码纠错方案,根据比特错误率的变化自适应地选择合适的码率进行译码,同时根据比特错误的非对称性调整译码似然比信息的权重值,以提升LDPC译码纠错性能,如图5和图6所示。

图5 不同保存时间译码迭代次数的变化

图6 不同LLR权重对译码迭代次数的影响

技术优势

1. 3D闪存器件可靠性模型

现有方法使用高斯分布、幂函数等数学模型适配真实的闪存单元阈值电压和原始比特错误率分布。考虑到3D闪存器件具有复杂多样的可靠性特征,该类模型难以应对多维干扰因素下和不同闪存芯片的实际分布形态,因此面临通用性差、精度低等挑战。本成果基于机器学习方法建立的3D闪存器件可靠性模型兼具通用性和高精度,能够应对闪存技术的快速发展和不同闪存芯片之间的特性差异。

2. LDPC纠错码

LDPC码有高纠错能力的优势,但是直接用于3D闪存纠错会面临挑战。一方面,由于LDPC码本身的软判决译码特性,需要在两个交叉的阈值电压分布之间多次施加读参考电压获取高精度的LLR信息,引起读延迟问题。另一方面,若获取的LLR信息精度较低,在译码过程中,会被送入变量节点和校验节点更新算法中进行频繁地迭代更新以提升精度,引起译码延迟问题,降低了3D闪存存储系统读性能。本成果利用3D闪存的错误特征优化LDPC译码算法,译码过程考虑错误率等因素对译码纠错性能的影响,能够提升LDPC译码纠错性能,从而容忍较多的比特错误和降低译码迭代延迟,保证可靠性的同时提升3D闪存存储系统读性能。

性能指标

1. 3D闪存器件可靠性模型

所提出的闪存单元阈值电压分布模型和原始比特错误率分布模型均能实现1.0e-4或以下的平均预测偏差;与现有最优模型相比,阈值电压分布模型最高实现4.9倍精度提升(或在同等精度下降低73%计算开销),原始比特错误率分布模型最高实现8.7倍精度提升。

2.LDPC纠错码

所提出的3D闪存错误特征感知的LDPC码纠错方案利用比特错误率的变化自适应调整LLR信息以提升LDPC码的纠错性能和降低译码迭代次。相比传统LDPC纠错方案,当原始误码率达到1.0e-2时,使用优化后LDPC码码率为0.80时,译码迭代次数能够降到10次以下。

研发阶段

3D闪存已经成为消费及工业类电子产品中的主要存储器件,并在数据中心和企业服务器中得到越来越广泛的应用。数据存储需求持续快速增长,对3D闪存器件的密度和可靠性不断提出更高要求。通用的高精度3D闪存器件可靠性模型与高性能纠错码技术是应对以上挑战的关键,对于闪存芯片制造商、闪存控制器和设备厂商具有重要意义。

扫码关注,查看更多科技成果